OpenAI的研究人员与乔治城大学安全和新兴技术中心以及斯坦福互联网观测站合作,调查大型语言模型如何被滥用于虚假信息目的。该合作包括2021年10月的研讨会,汇集了30名虚假信息研究人员、机器学习专家和政策分析师,并在一年多的研究基础上共同撰写了一份报告。本报告概述了语言模型如果用于增强虚假信息活动,将对信息环境构成的威胁,并介绍了一个分析潜在缓解措施的框架。

OpenAI的研究人员与乔治城大学安全和新兴技术中心以及斯坦福互联网观测站合作,调查大型语言模型如何被滥用于虚假信息目的。该合作包括2021年10月的研讨会,汇集了30名虚假信息研究人员、机器学习专家和政策分析师,并在一年多的研究基础上共同撰写了一份报告。本报告概述了语言模型如果用于增强虚假信息活动,将对信息环境构成的威胁,并介绍了一个分析潜在缓解措施的框架。

随着生成语言模型的改进,它们在医疗、法律、教育和科学等不同领域开辟了新的可能性。但是,与任何新技术一样,值得考虑的是它们如何被滥用。在反复出现的网络影响行动(通过隐蔽或欺骗的手段来影响目标受众的意见)的背景下,本文提出:

语言模型的变化如何影响操作,可以采取哪些步骤来减轻这种威胁?我们的工作汇集了不同背景和专业知识——具有在线虚假信息活动战术、技术和程序基础的研究人员,以及生成人工智能领域的机器学习专家——我们的分析基于这两个领域的趋势。

我们认为,在将语言模型用于大规模影响操作之前,分析人工智能支持的影响操作的威胁并概述可以采取的步骤至关重要。我们希望我们的研究能够为人工智能或虚假信息领域的新决策者提供信息,并促进人工智能开发者、政策制定者和虚假信息研究人员对潜在缓解策略的深入研究。

人工智能如何影响运营?

当研究人员评估影响运作时,他们会考虑参与者、行为和内容。由语言模型驱动的技术的广泛可用性有可能影响这三个方面:

参与者:语言模型可以降低运行影响操作的成本,将它们置于新的参与者和参与者类型的范围内。同样,自动制作文本的雇佣宣传人员可能会获得新的竞争优势。

行为:使用语言模型的影响操作将变得更容易扩展,并且当前昂贵的策略(例如,生成个性化内容)可能变得更便宜。语言模型也可能使新的策略出现,比如聊天机器人的实时内容生成。

内容:与宣传者相比,由语言模型驱动的文本创建工具可能会产生更有影响力或更有说服力的信息,特别是那些缺乏必要的语言或文化知识的人。它们也可能使影响力操作不那么容易被发现,因为它们反复创建新内容,而不需要诉诸复制粘贴和其他明显节省时间的行为。 我们的底线判断是,语言模型将对宣传人员有用,并可能改变在线影响操作。即使最先进的模型是私有的或通过应用程序编程接口(API)访问控制的,宣传人员也可能会被开源替代品所吸引,而国家可能会自己投资这项技术。

重要的未知数

许多因素会影响语言模型在影响操作中是否被使用以及在多大程度上被使用。我们的报告深入探讨了这些考虑因素。例如:

善意的研究或商业投资会产生哪些新的影响力?哪些参与者将对语言模型进行重大投资?

什么时候易于使用的生成文本的工具会公开可用?为影响操作设计特定的语言模型,而不是应用通用的语言模型,会更有效吗? 是否会制定规范,抑制那些利用人工智能进行影响力操作的行为者?行动者的意图将如何发展?

虽然我们期望看到技术的传播,以及语言模型的可用性、可靠性和效率的提高,但关于未来的许多问题仍未得到解答。由于这些关键的可能性可以改变语言模型如何影响操作,因此减少不确定性的额外研究是非常有价值的。

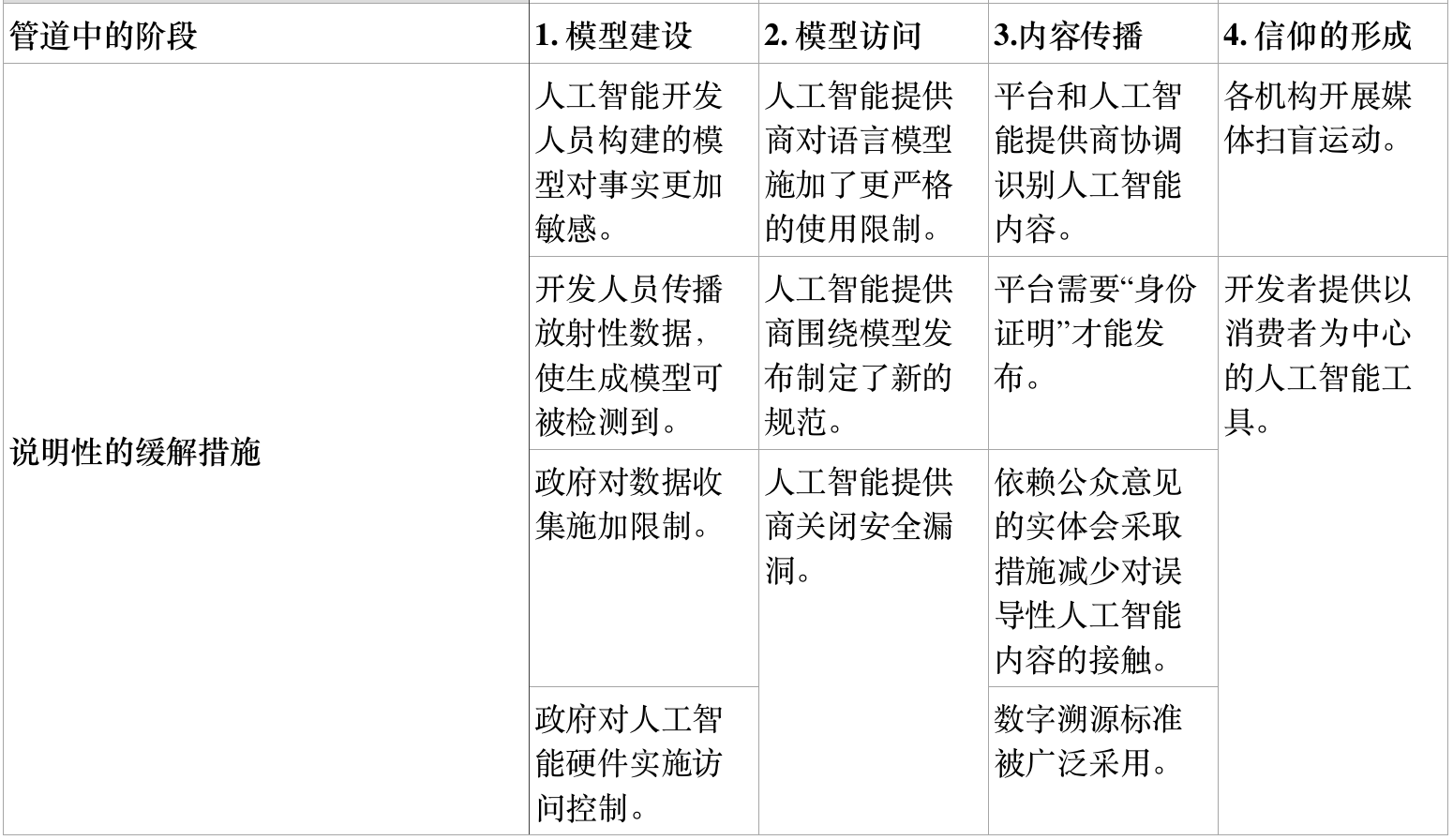

缓解框架

为了指明前进的道路,报告列出了从语言模型到影响操作流程的关键阶段。这些阶段中的每一个都是潜在缓解的一个点。为了成功地利用语言模型进行影响操作,宣传人员将要求: (1)模型存在, (2)他们可以可靠地访问该模型, (3)他们可以传播模型中的内容, (4)最终用户受到影响。如下所示,许多可能的缓解策略都遵循这四个步骤。

如果存在缓解,它是可取的吗?

仅仅因为缓解措施可以减少人工智能影响行动的威胁,并不意味着应该实施。一些缓解措施本身也存在下行风险。其他的可能不可行。虽然我们没有明确支持或评估缓解措施,但该文件为政策制定者和其他人提供了一系列指导性问题,供他们考虑:

技术可行性:拟议的缓解措施在技术上是否可行?它是否需要对技术基础结构进行重大更改?

社会可行性:从政治、法律和制度的角度来看,缓解措施是否可行?它是否需要昂贵的协调,关键参与者是否被激励去实施它,在现有的法律、法规和行业标准下它是否可行?

下行风险:缓解的潜在负面影响是什么,它们有多重要? 影响:拟议的缓解措施在减少威胁方面的效果如何?

我们希望这一框架将激发对其他缓解战略的想法,并希望指导性问题将帮助相关机构开始考虑各种缓解措施是否值得追求。

这份报告远不是关于人工智能和影响力运作未来的最终定论。我们的目标是确定当前的环境,并帮助制定未来研究的议程。我们鼓励任何有兴趣合作或讨论相关项目的人与我们联系。