在当今数字化的世界中,人工智能技术正不断地演进和创新,大型语言模型(LLMs)作为其中的佼佼者,在自然语言处理领域取得了显著的成就。为了更好地探索和应用大型语言模型的技术,Abacus.AI推出了全新的短文《长上下文LLMs:Giraffe的冒险》。

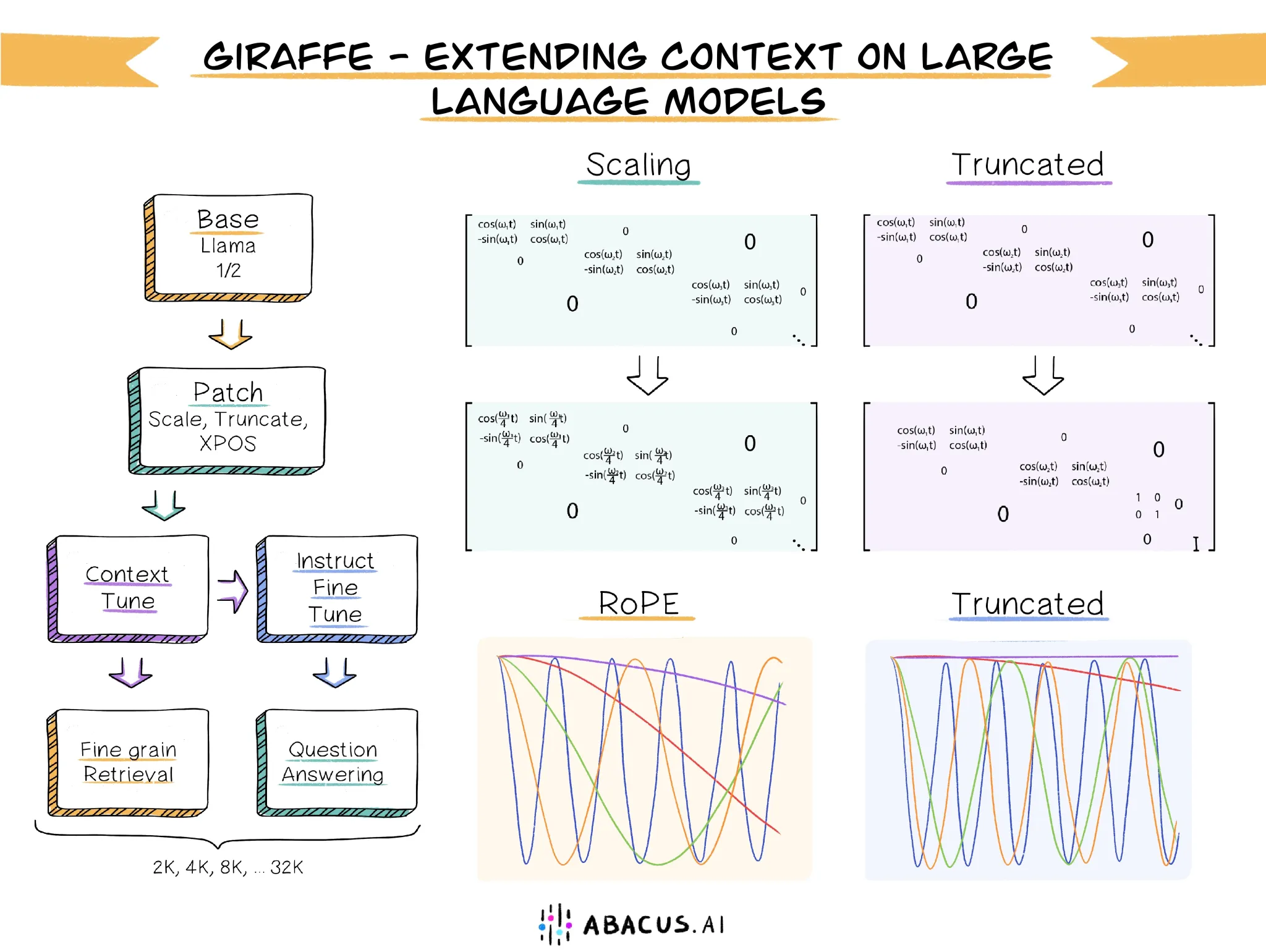

Giraffe:扩展上下文长度的新型模型

Giraffe是一个全新的模型家族,是从之前发布的基础LLaMA和LLaMA2进行微调而来的。其中包括了4k Giraffe和16k Giraffe,它们是从LLaMA进行微调得到的,以及32k Giraffe,它是从LLaMA2进行微调得到的。这些模型的权重已经在HuggingFace上发布。此外,Abacus.AI还向研究界发布了训练代码、评估数据集和评估脚本。

探索上下文长度外推

这篇论文探讨了大型语言模型的上下文长度外推问题,近年来大型语言模型在自然语言建模任务中取得了极大的成功。上下文长度外推是指将在短上下文长度上训练的大型语言模型用于在更长的上下文长度上进行评估,而无需进一步对长上下文进行训练。拥有能够外推到更长上下文的模型对于一系列任务至关重要。例如,如果您想要从自己拥有的大量数据中检索信息,拥有更大的上下文容量可以使模型一次性处理更多的数据,从而在复杂的检索任务中减少错误。这也可能对于维护长时间对话(例如与AI聊天机器人)或要求LLM在大型现有代码库上进行编码都非常重要。

为什么不能直接在更长的上下文上训练模型?

这其中的主要原因是现代LLM架构的一个关键组成部分,称为自注意力(self-attention),当上下文长度增加时,其内存和计算资源的需求将呈二次方增加,因此在没有足够的GPU、时间或金钱的情况下,很快就会无法训练更长的上下文。因此,拥有一种可以零-shot外推到从未见过的上下文长度的方法至关重要。

新方法的探索和测试

在最近关于上下文长度外推的研究中,已经提出了许多方法。在这篇论文中,我们汇集了我们认为最突出的方法,并进行了彻底的测试,以确定哪些方法最有效。我们还提出了一些新的方法,其中之一被我们称为“截断”,并显示出一些有希望的结果。

新任务的引入

在评估LLM性能时,选择合适的评估方法是一个难点。文献中最常用的度量标准是下一个标记的困惑度(perplexity),它衡量模型在给定前一个上下文的情况下预测下一个标记的能力。然而,我们认为文档的困惑度测量通常允许通过在整个可用上下文的一小部分上产生合理一致的文本分布来实现良好的性能。我们在论文中展示,困惑度对于区分模型在长上下文性能方面的敏感性较低,与我们引入的更强调模型召回准确性而非文本连贯性的新任务相比。

这些新任务是LongChat-Lines、FreeFormQA和AlteredQA。其中,LongChat-Lines在LongChat引入的基于键值检索的任务基础上延伸到更长的上下文。FreeFormQA和AlteredQA基于维基百科的自然问题数据集,是问答数据集。我们将这三个任务作为HuggingFace数据集发布。

未来展望

在LLMs上下文长度外推领域仍然存在许多待解决的问题。正如我们在论文中展示的那样,我们调查的方法目前没有完全满足能够真正外推而不会出现性能下降的要求。我们对进一步研究这个领域感兴趣,并寻找解决这些问题的方法。请继续关注!

总结

在大型语言模型的领域,探索如何在不断变化的上下文中进行优化是一个具有挑战性的课题。Abacus.AI通过Giraffe模型的研究,为我们带来了更多对于上下文长度扩展的理解和方法。通过不断的研究和探索,我们有望在这个领域取得更多的突破,让大型语言模型在更广泛的应用场景中发挥更大的作用。

文章来自ChatGPT3.5