摘要:

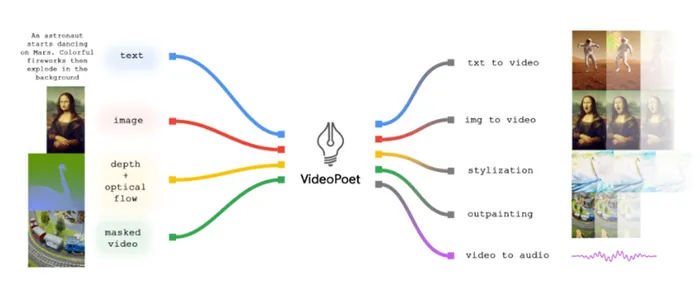

Google最新发布的VideoPoet是一款多模态模型,能够接受文本、视频、图像和音频等多种输入,用于生成、编辑和风格化视频。与其他扩散式视频模型不同,VideoPoet在一个大型语言模型中集成了多种视频生成能力,为用户提供了更广泛的创作选择。

介绍:

近年来,人工智能在数字化软件领域的应用不断拓展,Google推出的VideoPoet再次引领了多模态视频生成的创新。该模型不仅能够接受文字、图像、视频和音频等多种输入,还具备零-shot能力,即可以在未经过训练的情况下创建内容。本文将深入探讨VideoPoet的架构、训练方式以及其强大的多模态生成能力。

VideoPoet的架构:

VideoPoet采用了解码器架构,与传统的扩散模型不同,它在一个大型语言模型(LLM)中整合了多种视频生成能力,包括文本转视频、图像转视频、视频风格化、视频修复与生成音频等。这种综合性的设计使得用户可以更灵活地创作各种类型的内容,无需依赖专门训练的组件。

该模型的零-shot能力使其能够在未见过的内容上进行创作,通过两步训练过程,即预训练和任务特定适应,为用户提供了更大的创作自由度。此外,VideoPoet是一个自回归模型,通过回顾其先前生成的内容来产生输出,这进一步增强了其生成的连贯性。

VideoPoet的应用场景:

VideoPoet展示了令人印象深刻的应用场景,包括文本到视频的生成、图像到视频的创作、零-shot视频风格化、视频到音频的转换等。通过文字提示,用户可以创作出栩栩如生的视频场景,实现对已有视频的风格调整,甚至能够通过视频生成音频。

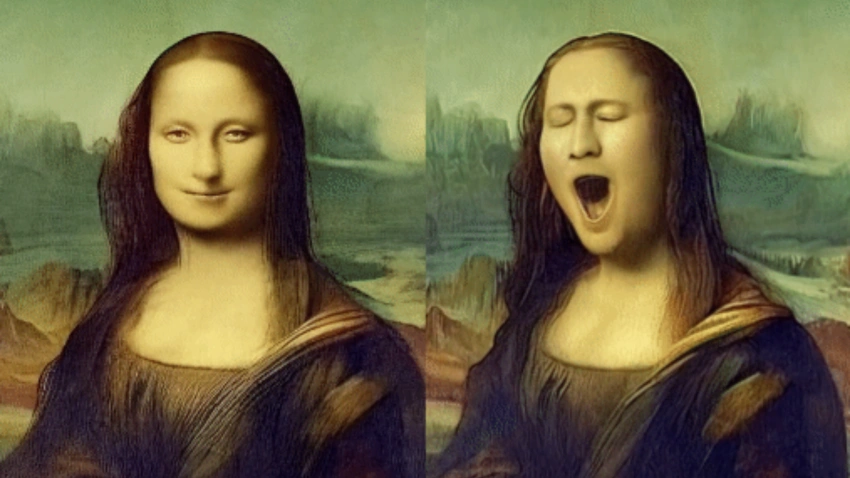

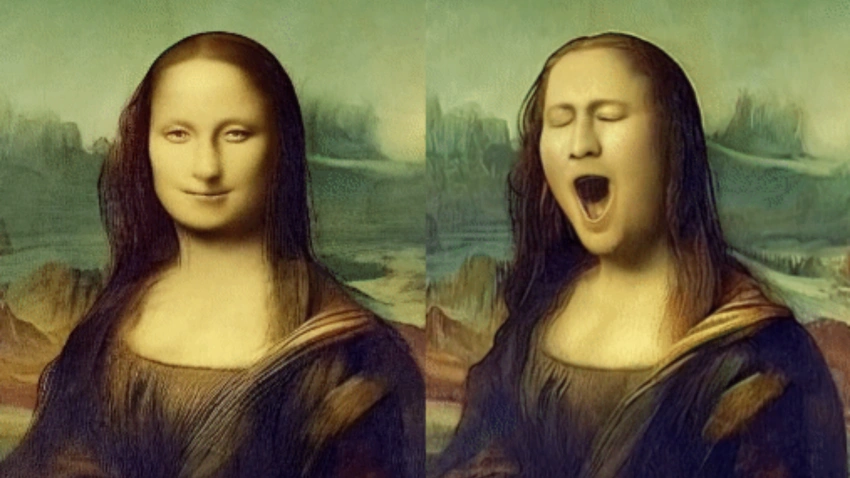

该模型的长视频生成、编辑和摄像机运动功能为用户提供了更广泛的创作可能性。通过条件预测,VideoPoet能够克服生成长视频的难题,并通过链式操作保持视频的外观一致性。此外,用户还可以利用文本提示改变视频中物体的运动方式,例如通过提示让蒙娜丽莎打哈欠。

未来展望:

研究人员表示,VideoPoet在多模态视频生成领域展现出巨大的潜力,未来的发展方向包括支持更多的“任何到任何”生成,例如文本到音频、音频到视频以及视频字幕等。尽管目前VideoPoet尚未公开提供,但通过官方网站演示,我们已经看到了其惊人的创作能力。

在不断发展的人工智能领域,VideoPoet的发布标志着多模态生成模型的新里程碑。其强大的创作功能为数字化软件领域带来了新的可能性,同时也激发了人们对于AI在内容创作中的无限想象。

原文:https://aibusiness.com/nlp/google-s-videopoet-a-multimodal-model-that-generates-video-audio 文章来自ChatGPT3.5