引言 TinyLlama项目历经数月的训练,终于推出。这个备受期待的开源模型小巧而强大,将训练在千亿标记的模型能力打包成适用于边缘设备的移动友好版本。

TinyLlama的诞生

TinyLlama项目始于去年9月,由一组开发人员试图在千亿标记上训练一个微小的模型。经过辛勤工作和一些挫折,TinyLlama团队现在发布了这个模型。它有十亿个参数,大约在三个周期内,也就是训练数据的循环中,训练了约一千亿标记。

根据论文描述,TinyLlama的性能优于现有开源语言模型,包括Pythia-1.4B、OPT-1.3B和MPT-1.3B等相似规模的模型。

TinyLlama的应用潜力 TinyLlama的潜在用途包括部署在边缘设备上,因为它仅占用637 MB。该模型甚至可以用于辅助更大模型的推测性解码。团队引用了前特斯拉高级AI总监、现任OpenAI成员Andrej Karpathy的教程。

该模型本身被设计为Llama 2的紧凑版本,Meta的开源语言模型,甚至拥有相同的架构和标记器,这意味着它可以在构建在Llama基础上的项目中轻松插拔。

尽管体积小巧,TinyLlama可以用于下游任务,团队背后将其宣传为“语言模型研究领域中研究人员和从业者的有吸引力平台”。

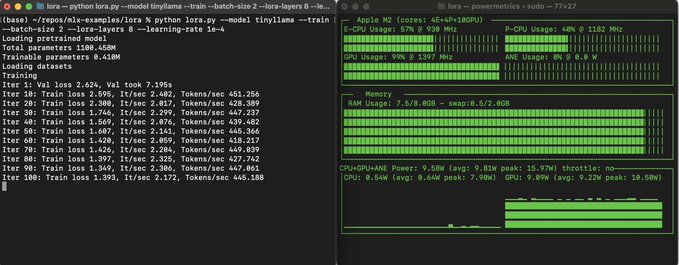

例如,苹果机器学习研究科学家Awni Hannun使用仅8GB Mac Mini通过MLX(苹果的开源训练工具套件)在本地对TinyLlama进行了精调。

“凭借其紧凑的架构和令人期待的性能,TinyLlama可以在移动设备上实现最终用户应用,并作为测试与语言模型相关的各种创新想法的轻量级平台,”这个微型模型的团队表示。

并且更多TinyLlama版本即将推出,开发人员计划开发“改进版本”,扩展其在各种任务中的性能和灵活性。

获取TinyLlama

你可以通过GitHub免费下载TinyLlama,所有模型检查点也可用。根据其Apache-2.0许可证,TinyLlama适用于商业用途。

Code: https://github.com/ml-explore/mlx-examples/tree/main/lora

团队建议目前使用TinyLlama的微调聊天版本,因为基础模型的“学习速率尚未冷却”。

微型模型崛起 最近涌现出一波较小的AI模型,公司希望减少硬件运营成本。

例如,微软的Phi项目致力于制作数十亿参数规模的小型模型,但具有超越更大模型的能力。去年12月推出的Phi-2在尺寸上超过同规模模型多达25倍。

即将发布的还有Gemini Nano,谷歌新旗舰基础模型的小版本,预计尺寸约为32亿参数。

根据姐妹研究公司Omdia的首席分析师Bradley Shimmin的说法,这些较小的模型表现良好,因为它们是在更大模型生成的合成数据上进行训练的。

“合成数据已经推动了我们在生成式AI领域看到的许多创新,目前许多这些小型模型都通过它们与OpenAI的GPT等前沿模型相匹敌的能力,令人瞩目,”他说。

本文来自ChatGPT3.5