概要: 微软发布了Python风险识别工具包(PyRIT),这是一个用于生成式AI系统的红队测试工具,可帮助识别潜在风险。这项工具已在微软AI红队内部使用,经过了实战检验。

-

微软发布Python风险识别工具包(PyRIT) 微软发布了Python风险识别工具包(PyRIT),用于生成式AI系统的红队测试。这项工具是微软AI红队用来检查其生成式AI系统风险的工具之一,其中包括Copilot。

-

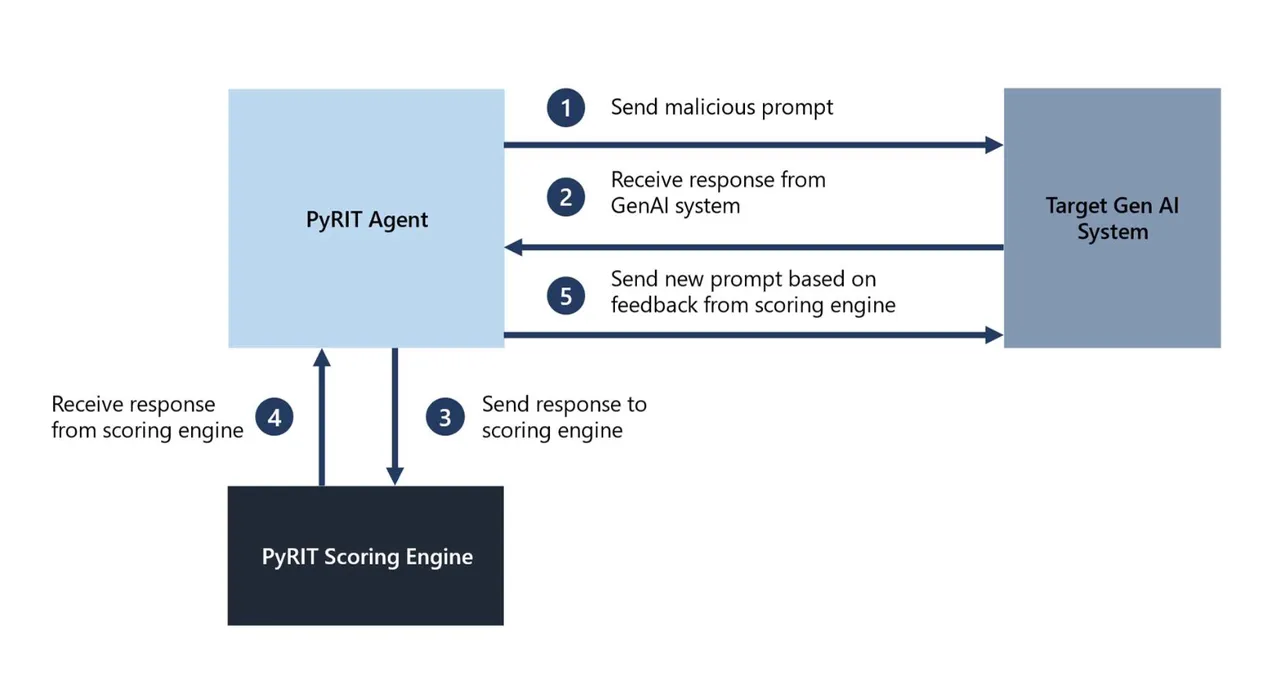

PyRIT的工作原理 PyRIT可以生成数千个恶意提示,以测试生成式AI模型,并评分其响应。它通过向生成式AI系统发送恶意提示,然后使用评分代理给系统打分,再根据以前的评分反馈发送新的提示,从而识别潜在的风险。

-

微软红队对生成式AI系统的挑战 微软在过去一年对60多个高价值的生成式AI系统进行了红队测试。他们发现,与传统AI或传统软件相比,对这些系统进行红队测试的过程存在巨大差异。这是因为微软不仅要考虑通常的安全风险,还要考虑到负责任的AI风险,例如确保不能有意地生成有害内容,或者模型不会输出虚假信息。

-

PyRIT的优势 微软表示,PyRIT的最大优势在于它帮助微软的红队工作更加高效,显著缩短了任务所需的时间。例如,在对一个Copilot系统进行红队测试时,他们能够在几个小时内而不是几周内选择一个有害类别,生成数千个恶意提示,并使用PyRIT的评分引擎评估Copilot系统的输出。

-

工具的可用性 PyRIT工具包现已提供,用户可以立即访问,并包含一系列演示以帮助用户熟悉该工具。此外,微软还将举办有关PyRIT的网络研讨会,演示如何在生成式AI系统的红队测试中使用它,用户可以通过微软的网站注册参加。

微软发布PyRIT工具包的举措是针对生成式AI系统可能存在的潜在风险,为保障AI系统的安全性和可靠性提供了一种新的方法。这对于当前广泛应用的AI技术来说是一个重要的步骤,有助于减少因生成式AI系统出现问题而可能带来的负面影响,同时提升了对AI系统的监管和管理能力。