Haiper AI视频平台宣布正式推出,并计划通过其全感知能力构建人工智能(AGI)。该平台由前Google DeepMind研究人员Yishu Miao和Ziyu Wang创立,最近获得了Octopus Ventures 1380万美元的种子轮融资。Haiper提供文本提示生成高质量视频的平台,并计划利用资金扩展基础设施和改进产品,朝着构建能够内化和反映人类理解世界的AGI迈进。

伴随着OpenAI即将推出的AI视频平台Sora引发热议,竞争对手开始纷纷加大力度提升各自的产品。就在几天前,Pika Labs推出了与其产品相关的口型同步技术。现在,一个全新的AI视频初创公司“Haiper”从隐秘状态中走出,通过Octopus Ventures获得了1380万美元的种子轮融资。

Haiper [https://haiper.ai/] 由前Google DeepMind研究人员Yishu Miao(CEO)和Ziyu Wang创立,总部位于伦敦。该公司提供了一个平台,允许用户通过文本提示生成高质量视频或为现有图像添加动画。与Runway和Pika Labs等现有AI视频工具相比,Haiper在技术上拥有自己的视觉基础模型,但从早期测试结果来看,与OpenAI的Sora相比仍有差距。

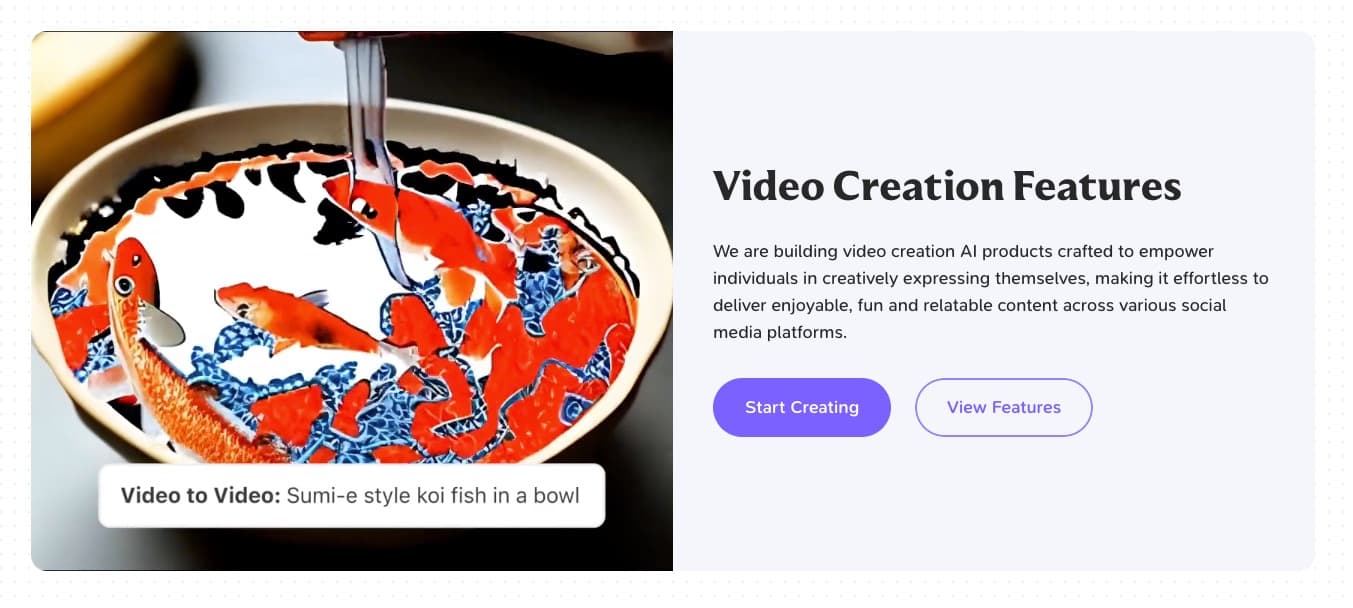

Haiper目前提供的AI视频平台与Runway和Pika类似,为用户提供一个网络平台,他们可以在上面输入自己选择的文本提示,开始创建他们可以想象到的任何东西的AI视频。该平台目前提供了生成标清和高清视频的工具,尽管高清内容的长度仍受限于两秒,而标清内容最长可达四秒。低质量视频工具还带有控制运动级别的选项。

在我们测试产品时,高清视频的输出更加一致,可能是由于长度较短,而低质量的视频则经常出现模糊,并在运动较大时,主题的形状、大小和颜色发生变化。与Runway不同,目前没有延长生成视频的选项,尽管公司声称计划很快推出这一功能。

除了文本到视频的功能外,该平台还提供工具,让用户上传和为现有图像添加动画,或通过文本提示更改视频的样式、背景颜色、元素或主题。Haiper声称,该平台和其基础视觉模型可以适用于各种用例,从社交媒体内容到为工作室生成内容等商业应用。然而,该公司尚未分享任何商业化计划,并继续免费提供技术。

随着这一轮融资,Haiper计划通过用户反馈迭代,并发布一系列大型训练模型,以增强AI视频输出的质量,潜在地弥合市场上竞争对手之间的差距。随着公司扩大这项工作,它将努力增强模型对世界的理解,从而创建能够复制现实情感和物理元素的AGI,包括光线、运动、纹理和物体之间的互动,从而创造出真实的内容。

Miao在一份声明中表示:“我们的最终目标是构建一个具有完全感知能力的AGI,它具有无限的创意潜力。我们的视觉基础模型将是AI深入理解世界物理规律、在生成视频时复制现实本质的一大飞跃。这样的进步为AI理解、融合和增强人类叙事打下了基础。”

Haiper期望其下一代感知能力将使其技术甚至超越内容创作,影响其他领域,包括机器人技术和交通运输。这种视频AI的方法使其成为人工智能领域备受关注的公司。