微软发布「小钢炮」Phi-4:小模型也能干大事!这些场景将迎来AI革命

大家好,今天要和大家聊聊微软刚扔出的一枚AI深水炸弹——Phi-4系列模型。别看这两个新模型(Phi-4-Multimodal和Phi-4-Mini)参数只有38亿和56亿,它们的本事可一点不比那些动辄千亿参数的"大块头"差!

![]() Phi-4-Multimodal首次实现「文字+图片+语音」三模态同时处理。想象一下,未来你对着智能眼镜说"帮我分析这张电路图",它不仅能听懂指令,还能看懂图纸并给出维修建议。更厉害的是,微软研发的"混合LoRA"技术解决了多模态相互干扰的业界难题,就像让三个大脑共享一个身体还能完美协作。

Phi-4-Multimodal首次实现「文字+图片+语音」三模态同时处理。想象一下,未来你对着智能眼镜说"帮我分析这张电路图",它不仅能听懂指令,还能看懂图纸并给出维修建议。更厉害的是,微软研发的"混合LoRA"技术解决了多模态相互干扰的业界难题,就像让三个大脑共享一个身体还能完美协作。

Phi-4-Mini在GSM-8K数学测试中拿下88.6分(满分100),超过很多80亿参数的模型。做个对比:这相当于让初中生参加高考数学,结果考得比高中生还好!在需要图像推理的科学题上,它甚至能根据设计图自动生成施工方案。

传统AI需要大型服务器支持,而Phi-4系列能在普通电脑甚至手机芯片上运行。日本Headwaters公司实测显示,在工厂网络不稳定的环境下,Phi-4处理质检图像的速度比云端AI快4倍,这对自动驾驶、远程医疗等实时场景意义重大。

美国AI公司Capacity用Phi系列改造数据处理系统后,预处理成本直降78%。他们的产品总监说:"就像突然给团队配了10个永不疲倦的数据分析师,而且不用买昂贵显卡"。这验证了小模型在商业落地的可行性。

目前Phi-4已登陆Azure平台和Hugging Face社区,开发者用RTX4090显卡就能跑起来。想象一下,未来工厂的摄像头、超市的收银机、甚至你的智能手表,都可能内置这样的"迷你大脑"。

Qodo开源代码嵌入模型:小身材碾压巨头,企业开发迎来新神器

今天凌晨,一家名为Qodo的AI代码质量平台(前身Codium)扔出一颗技术核弹——开源发布1.5B参数的代码嵌入模型Qodo-Embed-1-1.5B。这个只有同行1/5体量的模型,竟在权威测试中击败OpenAI和Salesforce的旗舰产品,引发技术圈震动。作为关注AI编程工具的博主,我带你看懂这场技术变革背后的门道。

代码嵌入模型:企业AI的新战场 过去两年,AI编程工具一直聚焦在「写代码」这件事上。但当企业代码库膨胀到上亿行时(比如某银行系统代码量相当于300部《战争与和平》),单纯生成新代码已不够用。就像图书馆管理员不仅要会写新书,更要能在海量藏书中快速找到特定段落。

代码嵌入模型就是解决这个痛点的核心技术。它能把代码转化为数学向量,让计算机理解代码之间的语义关联。想象一下:当程序员输入"用户登录验证模块",系统能立即从千万行代码中精准定位相关函数,这就是代码嵌入模型的价值。

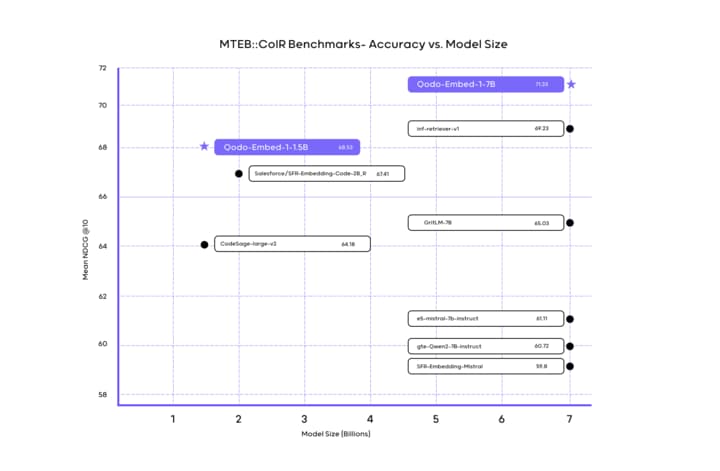

Qodo的三大技术突破 小体积大能量 在代码检索基准测试CoIR中,Qodo以70.06分碾压Salesforce(67.41)和OpenAI(65.17)。更惊人的是,它的参数规模仅有OpenAI同类的1/5(1.5B vs 7B),意味着企业用普通显卡就能运行,成本直降80%。

区分「双胞胎代码」的绝活 CEO Itamar Friedman举了个经典案例:存款(deposit)和取款(withdraw)函数可能只差一个"±"号,但功能完全相反。传统模型容易混淆这类代码,而Qodo通过「合成数据+真实代码」的特训方案,让模型能识别这种细微差异,避免引发灾难性错误。

十国语言特攻队 支持Python、Java等十大主流语言,且能准确区分不同语言的代码片段。比如不会把JavaScript的箭头函数和Java的Lambda表达式混为一谈,这对跨国企业的多语言代码库至关重要。

三、企业级解决方案的秘密武器 动态更新系统:代码库每次修改后,嵌入向量自动刷新,解决传统模型「学完就过时」的痛点 混合部署模式: 开源版:Hugging Face免费获取(OpenRAIL++-M协议) 企业版:支持私有化部署,与NVIDIA、AWS深度集成 云服务:自动扩展版本,适合持续迭代的大型项目

用RTX 4090显卡就能跑动亿级代码库检索,中小企业首次获得AI代码管理能力,通过代码相似性分析,可自动检测「复制粘贴编程」导致的技术债务。 这场技术突破揭示了一个趋势:AI编程工具正在从「辅助写代码」向「理解代码生态」进化。对于每天面对海量代码的企业开发者来说,Qodo这类工具可能比ChatGPT更具实用价值。毕竟在真实开发中,找到现成解决方案往往比从头生成更高效可靠。